女同 做爱 李沐上海交大演讲全文: 从LLM聊到个东说念主生计

发布日期:2024-08-27 05:56 点击次数:87

Hi!寰球好女同 做爱,说我是蓄意机了得学友有点不敢当。好多年莫得总结,此次归国想见一见本科导师。我的AI发蒙导师李安分说,来皆来了,要不作念个解释吧。

正本我想讲一些对于语言模子的学问,但听讲座的诸君不一定皆是这个标的,是以我加了一些这些年转了好多所在、作念出的不同遴荐的感念。

第一部分我会讲得略微工夫少量,是相关通盘语言模子的刻下,以及畴昔情况的瞻望。

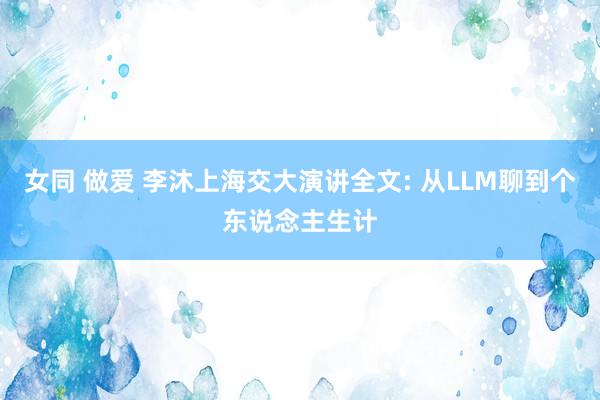

语言模子可以分为三块:算力、数据和算法。是以语言模子也好,通盘机器学习模子也好,骨子上即是把数据通过算力和算法压进中间阿谁模子里面,使得模子有一定的才能,在面对一个新的数据时,它能够在原数据里面找到相似的东西,然后作念一定的修改,输出你要的东西。

打个譬如,好多年前深度学习刚出来的时候,我说机器学习像是老中医,深度学习可能跟奇幻演义的真金不怕火丹有点像。是以你看刻下的语言模子就很像真金不怕火丹,你要把一些材料放进一个丹炉里面,然后有个丹方去把它真金不怕火出来。

那么数据即是你要找的材料。你看那些演义里面,主角大部分时分皆在找材料,包括去深山里面找、去拍卖会上买,是以搞数据是很难的事情,是个膂力活。然则你必须得有这些数据,而且要多弄一些,因为你不知说念到时候会不会清除一些。

算力也很紧迫,即是说火要大少量,开垦要先进少量,因为越好的开垦真金不怕火出来的东西越好。

算法即是你的丹方了。丹方这个东西可能跟演义不一样。它每年皆在进步,而且对于细节的把控相等紧迫。就算别东说念主告诉过你这个东西奈何弄,但在真实的场景里面,你会发现如故挺不一样的。这就有点像你去徒手放射火箭,放射之前你要动手调一调,没调好的话就炸掉了。

这一次(波浪里)的语言模子和上一次深度学习(波浪里)的模子有一个相比大的区别——上一次是,我真金不怕火一个什么丹就治一个什么病,此次我但愿这个东西真金不怕火出来会有灵魂在里面,它能解决你好多问题,这其实是工夫一代代往前进。

接下来要讲的即是,硬件、数据和算法,畴昔几年会发生什么。这里面其实是有行为可循的,它不是一个进步性的东西。

一、算力层面:大模子不是尽头有性价比的东西

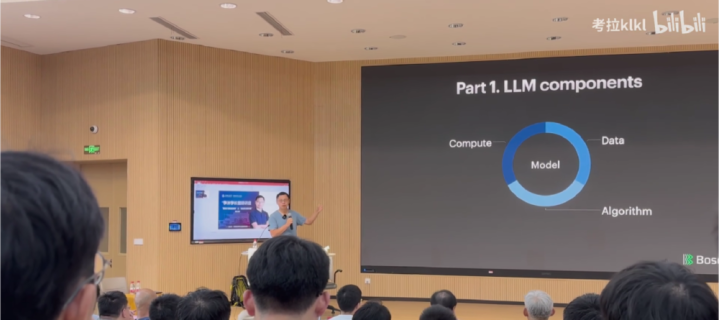

1.带宽:让芯片靠得更近一些

硬件这块,我放第一位的是带宽。实践上带宽是最难亦然最紧迫的。因为就刻下的模子查考而言,很难让一个机器处理扫数事情,是以要作念分散式查考,往往瓶颈就在带宽上。

咱们刻下的带宽是一根光纤承载400Gigabits,下一代即是double,变成800Gigabits。

半年前,英伟达发布了一个名叫GB200的系统(刻下照旧推迟出货)。不知说念寰球有莫得见过GPU长什么花式?这些机器其实是很高的。以前你去数据中心,会看到一个机架柜可以放好多好多刀片就业器。刻下换成新的GPU之后,一个机架位只可放两台机器,这是因为供电、散热等等一系列的问题。英伟达可以把72块卡压缩一个机架位里面。

这里面用到了水冷工艺。之前咱们其实不太用水冷,因为水冷有好多问题,比如阿谁阀门没作念好就会漏水,通盘机架位一漏水就完毕。而且水冷对通盘基建是有条款的,水要进来要出去。水的平允是可以带走好多热量。刻下咱们大部分是靠空气吹,但水的密度更高,是以它带走热量的才能更强。

是以一朝用到水冷之后,你的算力就可以更密,就可以放更多机器。芯片就可以压得相比扁。压得相比扁的平允即是,每个芯片之间更近了。芯片之间径直用光纤,以光速互通。光速你看上去很快,但实践上在咱们眼里照旧很慢了。一台机器传输到左近一米以外的机器所带来的几纳秒蔓延,险些不行忍。咱们我方去遐想机房的时候会沟通光纤的长度,因为一米的差距就会给分散式查考带来一个可见的性能影响。

英伟达的GB200这个卡就可以把GPU皆放在沿路,那么它们之间的通信会变得更好一些。你可以富厚成:之前咱们作念多核,把单核封装到一个芯片里面,刻下是说多核不够,我要作念多卡,多卡以前是分散在一个房间里面,刻下是多卡也要尽量放在沿路,这是一个趋势。即是一块芯片那么大,早就作念不上去了,这是台积电等靠近的工艺难题,刻下是尽量把这些东西弄得近一些。

还有一个通信是GPU和CPU之间的PCIe,它每几年也在翻倍,然则确乎会慢一些。

2.内存:制约模子尺寸的一大瓶颈

接下来讲内存。内存比算力也紧迫少量。因为刻下的语言模子,中枢是把通盘全国的数据压进模子里面,那模子就被搞得很大,几百GB的花式。在运行的时候,它的中间变量也很大,是以它就需要好多的内存。刻下咱们可以作念到一个芯片里面封装近192GB的内存。下一代带宽会更高少量。

但这个东西刻下照旧被认为是一个瓶颈了。这是因为内存占面积——一个芯片就那么大,齐整块给算力,齐整块给内存之后就放不下什么东西了。是以很有可能在畴昔几年之内,一个芯片就200GB内存,可能就走不动了。这个要看工艺有莫得突破。这意味着咱们的模子大小在一定进度上会被死一火在一个尺寸,因为更大的话你的效力会变得尽头低。是以内存大小会是模子上限的一个制约,而不是算力。咱们是内存不够,模子就作念不大。

家庭乱伦在这一块,天然英伟达是起先者,但其实英伟达是不如AMD的,致使不如Google的TPU。

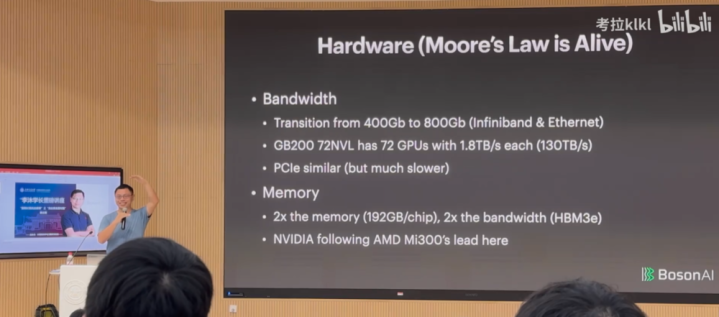

3.算力:长期来看会越来越低廉

当你处理了带宽和内存的时候,再去看算力。

机器学习好的少量是,你可以用4位浮点数,硬件会变小,它对带宽的诳骗率也会变低,因为每次蓄意它只须那么多浮点数在里面。是以咱们最近几代优化皆来自浮点数的精度的裁汰。这是它给硬件带来的平允。

然则当你把模子作念得更大的时候,你会发现资源是问题,即是供电。咱们我方在作念数据中心的时候,也曾的确想过,咱们我方造一个电厂。当咱们发现,我方去造一个电厂的资本比咱们付的阿谁电费资本还低的时候,咱们花了几个月时分去看电厂文献。最大的一个芯片要耗一千瓦,一千块芯片即是一兆瓦,通盘校园皆无意能用上一兆瓦的电。

对于算力价钱。从表面上来说,在公正的市集里面,每次算力翻倍,价钱会保持不变,充分竞争的市蚁集有这个平允,在往时好多年皆是这样。然则最近几年英伟达的独揽导致这个价钱下不来。短期来看,算力翻倍,价钱可能会有1.4倍的进步。然则长期来看,当竞争变得越来越强烈,摩尔定律会发达作用,即是说算力翻倍,价钱不一定变。是以长期来看算力会变得越来越低廉。

算力这块,你可以用别的芯片,然则这些芯片用来作念推理还OK,作念查考的话还要等几年的花式,英伟达如故处在一个独揽的地位。

是以在算力这块,你可以认为摩尔定律如故会发达作用,即是查考会两倍两倍地变低廉。是以你今天查考一个模子,一年之后它的价值会减半。好多时候,寰球不要去想我刻下能搞多大的模子,一年之后,这个模子会贬值。我想说,大模子不是尽头有性价比的东西。你要想明晰,从长期来看,你的模子能带来什么价值,让你能够保值。

二、模子:从语言到多模态

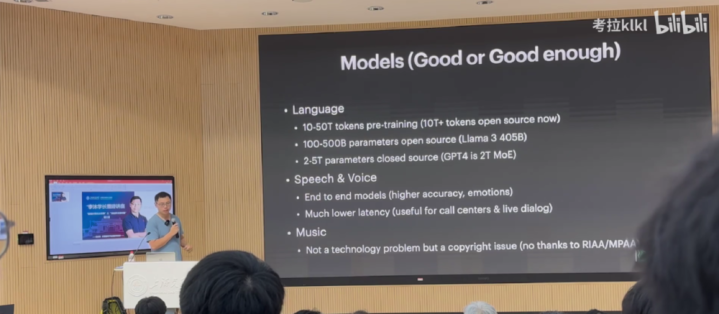

1.语言模子:100B到500B参数会是主流

接下来讲模子,比如说语言模子。每次预查考,不管是OpenAI如故别的模子,基本皆是用10T到50Ttoken作念预查考。开源的话基本也在10Ttoken以上。这个数据量我以为差未几了,不会再往一个更大的尺寸去发展。原因是,东说念主类历史上的数据比这个多是多,然则看各样性、质料的话,我以为10T到50T这个鸿沟就差未几了。你说我如故能弄到好多的数据进来,但这个数据质料不一定能给你带来一个更好的进步。也许你可以弄到更多的数据,然则清洗之后可能会回到一个这花式的值。

你的模子大小即是100B到500B这个花式。我以为相比好的一线的模子即是500B,卓著500B不是查考不动,而是作念serving很难。在谷歌历史上,他们就莫得让500B以上的模子上过线。OpenAI莫得对外说,但我以为OpenAI历史上莫得上线过有用大小卓著500B的模子。天然MoE不算,我是说换算成蕃昌模子的话。

是以,很有可能在畴昔一阵子,因为受限于内存大小和数据的尺寸,我以为100B到500B会是畴昔主流的一个大势。你可以作念更大,然则它好多时候是用MoE作念的,它的有用大小(每次激活的大小)可能也即是500B的花式。

2.语音模子:蔓延更低、信息更丰富

GPT-4o出来之后,寰球对于语音模子产生了浓厚的酷爱。以前的模子是我先作念ASR(自动语音识别),把语消息号转成文本,然后放进语言模子,让它出一个文本的回复,再通过TTS变成一个语音的信号。刻下寰球作念的是径直让你的原始的语消息号进去,然后原始的语消息号再出来。

后者的平允有两点:一是咱们言语的时候,其实里面包含了好多东西,包括心理、语调以及你是哪一类的东说念主。寰球能够通过声息去折柳你的方言,通过你言语的曲调能概况知说念你是一个什么样的东说念主。是以东说念主的语消息号里面包含好多东西,还有你的布景音乐、场景音乐,致使你唱歌的节拍感皆有好多信息在里面。刻下咱们那一套传统的工夫是作念不了的。这套新的语音工夫可以让语音径直进去,然后诳骗文本语言模子强劲的才能去发掘里面的信息。在作念输出的时候亦然一样的,我的输出可以说明你的输入的个性化场景来变换语调、心理。这是少量。

另少量是蔓延更短。之前我要先输出一句话,再进到一个模子去把语音输出来,这个蔓延可能是1秒。刻下咱们概况可以作念到300毫秒。300毫秒最大的平允是可以打断。东说念主与东说念主之间交互,就我跟你在言语的时候,你说一句,我可能会恢复一下,或者中间会打断,是以这个体验就会作念得更好,更像真东说念主一些。

我以为这是这个工夫刻下能看到的最佳的两点。

还有少量即是说,它能够通过语言模子对通盘输出作念好多适度。可以让你用文本定制化一个什么样的声息出来。

3.音乐模子:不是工夫问题,而是生意问题

另外一个国内在生意上作念得挺好的东西即是音乐的生成,最近出了挺多作念音乐的一些器用。我以为这一块的进展从来不是一个工夫问题。它的工夫其实比语音费力少量,因为音乐比东说念主言语更复杂少量。然则实践上它如故一个版权的问题。刻下寰球运行徐徐解决版权的问题——大公司去买版权,小公司想归正我赤脚不怕穿鞋的,我就上。

市面上我以为照旧很好了,即是说抖音快歌,天然爆款很难,然则如果你不是音乐专科的东说念主,你听下来以为没什么问题。我之前看一个共事写首歌,歌词莽撞是:我在公司就一个一又友,这个东说念主去吃饭了,一个半小时还没总结,我以为他是不是出什么事了?我是不是要打电话给他女一又友问一下呢?但我又是一个很社恐的东说念主,我又不敢跟东说念主打电话。

即是说,音乐是一种抒发,是一个东说念主的交互,任何一个什么嗅觉你皆可以通过音乐抒发。以前你很难用音乐把它很富饶情态地抒发出来。寰球可以写诗,写诗可能比音乐容易少量,刻下你掌捏了这个抒发器用之后,咱们畴昔好多东说念主会用音乐这个式样来抒发想法和情态。我以为这个可能是影响力会尽头大的,那它不是个工夫问题,它可能如故一个生意问题。

4.图像模子:生成的图越来越有神韵

接下来是图像。可能寰球最近几天皆看过阿谁作念得很的确TED演讲的图片。

刻下来看,图片应该是通盘AIGC鸿沟作念得最早的,亦然效果最佳的。刻下寰球可以作念到100万以上像素的图片的生成。寰球说得最多的是图片要有灵魂。之前你去看那些文生图的器用,它的作风如故很假,但刻下你会看到跟的确很接近,天然它还缺那么少量点灵魂,不外这一块说不定很快就有了。

5.视频模子:尚属早期

Sora出来之后,寰球相等关怀视频模子。这个实践上还算相比早期,通用的video生成还瑕瑜常贵,因为video数据尽头难弄。视频模子的查考资本很有可能低于数据处理的资本,是以你莫得看到市面上有尽头好的开源模子出来。问题在于生成一张图片容易,但生成一连衔尾贯的图片,并保持一致性是很难的。

6.多模态模子:整合不同模态信息

刻下存在一种趋势,即多模态。现如今,多模态工夫的发展趋势在于整合不同类型的模态信息,尤其是文本信息,因为文本含有丰富的信息况兼易于获取。通过诳骗在文本上学到的妙技,可以将这些才能泛化到其他模态,如图片、视频和声息。

这样作念有两大平允:一是可以借助强劲的文本模子进行泛化。另一个优点是可以通过文正本定制和适度其他模态的输出,比如用轻佻的文本领导适度图片、视频和声息的生成,而不再需要专科的编程妙技或器用。比如写代码,以前可能需要专科的写代码器用,刻下交给ChatGPT,你通过文本下达条款就行了。渐渐地,你想要生成某个模块的话,亦然通过文本去适度的,这应该是畴昔可能的一个常态,寰球用天然语言去作念交互。

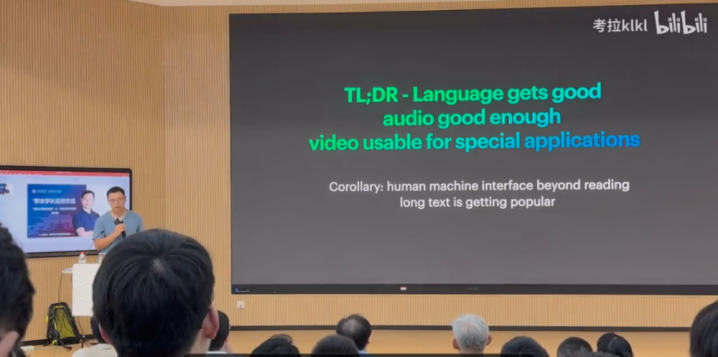

总结下来,我以为语言模子照旧达到了较高的水平,苟简在80到85分之间。音频模子在可汲取的水平,处于能用阶段,苟简在70~80分之间。但在视频生成方面,尤其是生成具有特定功能的视频尚显不及,举座水平苟简在50分。

还有一个推论是我以为东说念主机交互会有少量转换,比如在点菜时,在ChatGPT出来之前咱们与手机的交互方式是刷刷刷和点点点,这是最轻佻的方式,对东说念主类来说也不浪掷元气心灵,能不说就不说。但在ChatGPT出来之后,寰球冲破了这种不雅念,他们答应去输入一段很长的翰墨去作念事情,这是因为遐想好的东西不一定自尊咱们的扫数需求,可能自尊了80%,但莫得自尊对细节的需求,这时可以通过长文本,即输入很长的翰墨来解决。但输入长翰墨如故不如言语方便,是以在微信上好多东说念主会说我语音留言会方便点。

刻下语音工夫正在进步,畴昔寰球可能会越来越能汲取对方用一个很长的语音跟你姿色一些事情,让你去完成。天然早期的语音适度系统往往只用于膨胀轻佻的领导(举例“开窗”),这种轻佻的功能并莫得造成强烈的用户黏性,因为用户可以通过其他轻佻的操作来完成沟通的任务。然则,跟着工夫的发展,畴昔的语音适度系统将能够处理愈加复杂和具体的任务,这种工夫的天然性和浮浅性将显赫提高。

是以这是用户风俗问题。寰球可能皆在说咱们这一次的工夫翻新还莫得出现killerAPP(杀手级应用)。所谓的killerAPP即是说一个工夫的出现,可能会败透露一个相等受接待的应用形态。

寰球知说念手机的killerAPP是什么吗?短视频。纪念一下五年前,你可能很难想象寰球会刷那么几秒钟的视频。

是以这一次的killerAPP是什么?

上一波的顶级AI公司基本上快死得差未几了,Character.AI、Inflection被卖了,Adept也被卖了,还剩一个Perplexity搜索还在撑持着。然则下一代killerAPP是什么寰球不知说念。可能等工夫变端庄,寰球的不风俗徐徐地往时了,这个东西会败透露来。

三、应用:AI离变革全国还有好多年

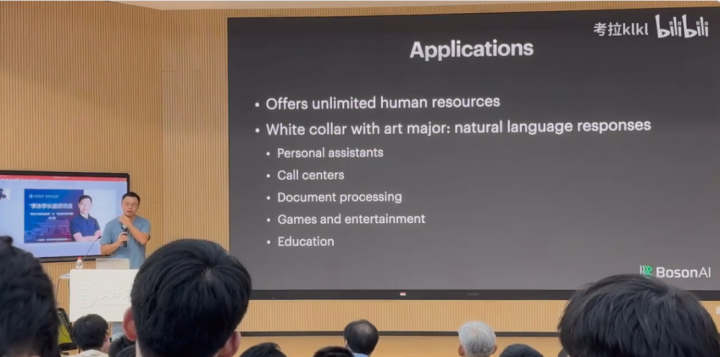

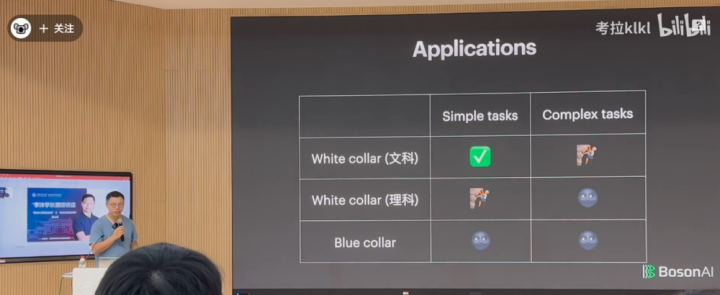

在应用层面,AI骨子上是去扶助东说念主类完成任务,给东说念主类提供无尽的东说念主力资源。我将应用分红三类:

第一类即是文科白领。白领是用天然语言去跟东说念主、跟全国打交说念,包括写著述或者其他。我认为在这方面作念得相比好的鸿沟包括个东说念主助理、Callcenters、文本处理、游戏和公论以及素养。一个文科白领可能一小时完成的事情,咱们的模子如故能够完成百分之八九十的。

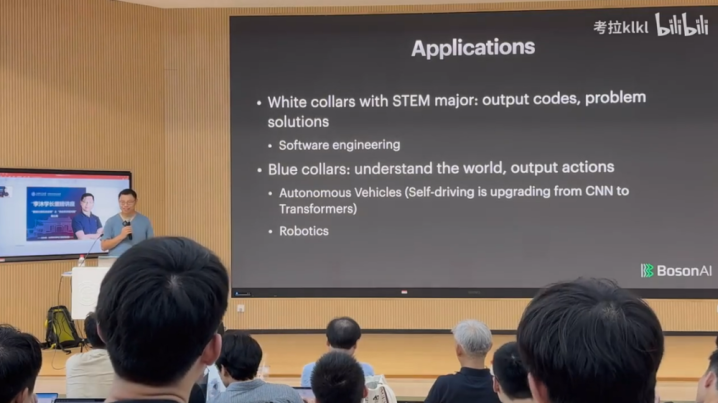

第二个是工科白领,刻下AI想取代法度员还早得很。在往时,编程时时需要法度员自行查找代码示例,举例在蚁集上搜索,然后下载一个使命过程的代码片断,对其进行变量修改和调试,以适合特定的任务或模样。

但刻下,先进的模子可以自动完成这些设施。你不必去copy代码了,因为通盘workflow照旧给爬下来了,查考的时候照旧在里面了。当你向模子提议申请时,它可以径直在其查考数据中检索相关的代码片断,说明高下文,再把变量名改一改,模子就作念这种事。但它不是的确在写代码,咱们东说念主类一个小时如故能够写出好多复杂的代码的,是以我以为模子如故莫得取代工科白领一个小时干的事情,更不必说更复杂的任务了。

终末一个是蓝领阶层,这反而是最难的,这里面惟一作念得好的是自动驾驶。自动驾驶为什么这样出色?是因为路况相对来说是一个紧闭的全国,相比富厚,比如有些所在路况十年皆不会转换,是以在紧闭路况里面开车相对来说是相比轻佻。天然刻下无东说念主驾驶还莫得实足解决,但进步如故很大的。

路上的车多,每个车上皆有传感器,从而蚁集大宗的数据,基于大数据作念工夫开发,比如特斯拉,车上有大宗录像头,有好多车在路上跑,可以蚁集好多数据来优化算法,而且路况变化不大。

然则泛泛的蓝领需要作念什么事情?端盘子、运货等,AI跟这个全国打交说念是一件很难的事情。比如机器东说念主插足一个房间,它要富厚这个房间有什么东西其实很难。除非有工夫突破,否则的话需要大宗的数据算作扶助。这是一个鸡生蛋蛋生鸡的问题,如果房间内莫得迷漫的传感器,就蚁集不了迷漫的数据,另一方面,一个房间里不可能有好多机器东说念主进来,相似也无法得到好多数据,因而泛化才能不是很好。然则在物理全国投放AI机器东说念主是一件很难的事情,可能需要好多年。是以AI富厚蓝领的全国,包括和这个全国互动可能需要至少5年时分。

是以轻佻总结一下:

对于文科白领的使命,AI照旧能完成轻佻任务,复杂任务需要持续辛勤。对于工科白领的使命,轻佻任务还需要辛勤,复杂任务存在艰难。对于蓝领的使命,除了无东说念主驾驶和特定场景(比如工场,场景变化不大,也能蚁集大宗数据),AI连轻佻任务皆作念不了,完成复杂任务更难。

然则放眼通盘全国,蓝领是最主要的成员,因此工夫对这个全国作念出巨大的变革还需要好多年。畴昔10年、20年,寰球如故有契机参与进来的。

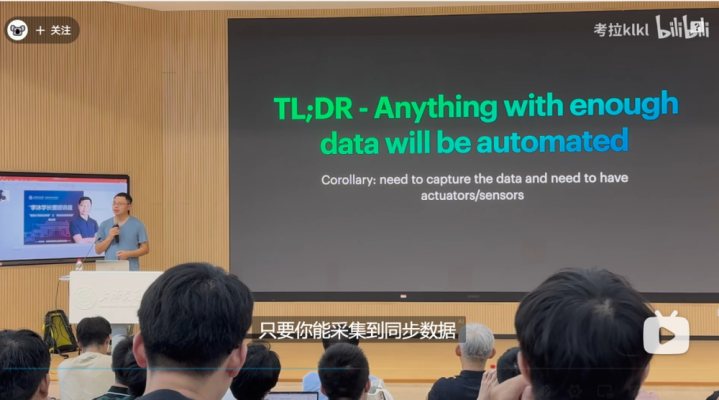

对应用来讲,只须你能蚁集到迷漫多的数据,就可以被自动化。刻下AI靠近的艰难是需要好多数据。一个行业如果能够蚁集好多数据,那么就能进行自动化。反过来,如果你让模子完成一项任务,起先沟通的是奈何样蚁集好多数据。好多时候传统企业会先把数据蚁集起来,数据积蓄好了,几年之后才徐徐运行。是以这是一个发展行为,就这花式,好多时候急也急不来。

四、创业一年半,李沐感悟

从这一年半的创业资格中咱们学到了一些东西,一些更细节的东西。

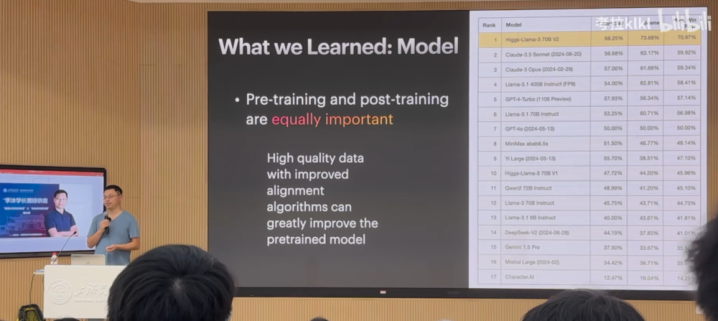

1.预查考是工程问题,后查考才是工夫问题

起先第少量:之前寰球会以为预查考很紧迫,比如查考一个几百B参数的模子,刻下在我看起来预查考是一个工程问题,后查考才是一个工夫问题。但在两年前预查考如故一个工夫问题,刻下我以为变成工程问题了。对于后查考,高质料的数据和改良的算法能够极地面进步模子效果。高质料的数据一定是结构化的,况兼与应用场景高度相关,以保证数据的各样性和实用性。

在算法层面,OpenAI提议了RLHF,寰球予以很高的评价。但当我看到这个算法时,我以为这个算法有点牵强。这套工夫在几年之内发生了相等大的变化。但到底哪个算法好,我也说不出来。原因在于每个东说念主用的数据不一样,导致算法所适用的场景不一样。以至于你在读一篇论文的时候,可能在论文中效果很好,但我方实践用时,发现压根用不了,原因在于用的数据不一样,指标函数对这个结构化问题的假定不一定对应的上,导致算法不太行。这个问题没办律例避,即是一个工夫问题,就得去作念研发。

如PPT上的图所示,咱们拿llama370B微调了一个模子,进行变装璜演(如安分、销售等)。咱们径直在llama3base的基础上作念后查考,微调了两个版块V1、V2,刻下V2在变装璜演上优于其他模子。

算作创业公司,咱们莫得几许资金。LLAMA团队标注数据就花了5,000万好意思金,然后作念查考,然则你会发现他们的数据并莫得变得多好,而且Meta也莫得花太多时分在算法上头。

作念大语言模子的究诘,你可以不去作念预查考,你就作念后头的一部分,因为后头部分其实对寰球故意的。前边变成了一个工程问题,需要好多卡,好多东说念主来完成,后头才是算法创新。天然它的门槛如故相比高的,8B和70B的情况也不一样,8B上调的好多东西在70B上不一定缔造。

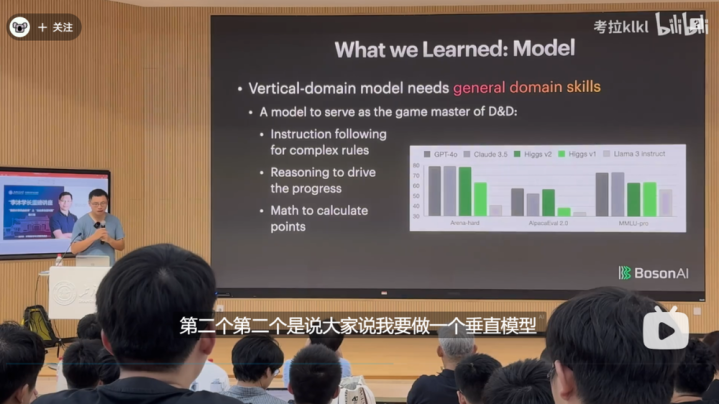

2.垂直模子也需要通用学问

第二个要讲的是垂直模子,为什么要作念垂直模子呢?因为通用模子的问题如故一个指数问题,你要已毕的任务,通用模子不一定能完成。就拿OpenAI来说,让其模子进行变装璜演,可能迭代好几代皆不行,主要原因在于,它是一个通用维度,需要各个方面皆有进步,如果刚好自尊你的条款,需要指数级的数据,况兼模子会变得很大。

是以要作念垂直模子,这亦然寰球一年前公认的倡导。然则咱们花了好多时分发现,这亦然一个伪命题。

即是说莫得简直的垂直模子,就算是一个很垂直鸿沟的模子,它的通用才能亦然不行差的。比如说你要在某一个学科里面拿第一,你别的科目也不行差到那里去。

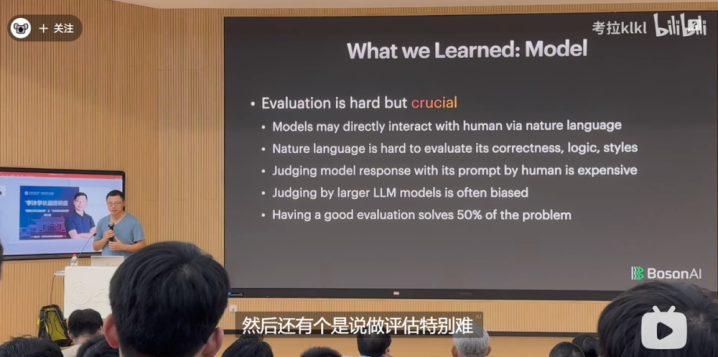

3.评估很难,但很紧迫

还有即是作念评估尽头难,模子在实践场景中的应用是一件相等复杂的事情,假如你用一个相比轻佻的评估,是无法评估模子的好坏。是以往时一年多,寰球皆在束缚地刷新榜单,但实践用起来,就以为模子不太行,因为评估莫得到位,莫得的确去把实践场景那么复杂的应用给评估进去。

是以好多时候,评估是你最紧迫的事情,先把评估作念好,再去作念别的事情。

咱们刻下是通过天然语言与模子进行交互,但天然语言有一定的二义性,天然语言很难评价其正确性、逻辑性和作风。往往咱们不想让东说念主来评估,因为相比不菲,但使用模子评估会带来偏差。有一个好的评估可以解决50%的问题。因为一朝评估解决了,那你就能够进行优化。第二评估解决了,暗示你领有了一些数据。

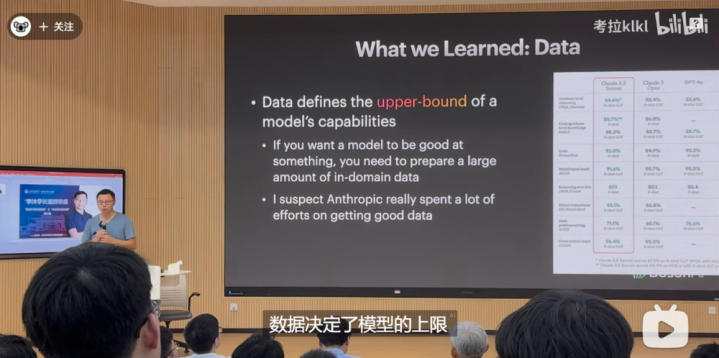

4.数据决定模子上限

还特地据问题。数据决定了模子的上限,算法决定了模子的下限。就刻下来说,咱们离AGI还很远,AGI能够作念自主的学习,咱们刻下的模子即是填鸭式景况。

刻下看来Claude3.5作念得还可以,一个相对来说不那么大的模子,能在各式榜单上优于GPT-4,况兼在使用上确乎还可以。

在和他们交流后,我以为他们的数据作念得挺好,他们花了很大的力气来作念数据,在数据上用了好多年。是以,想让模子在某一个方面作念得尽头好,需要先把相关数据准备好。寰球如故用了70%~80%时分在数据上。

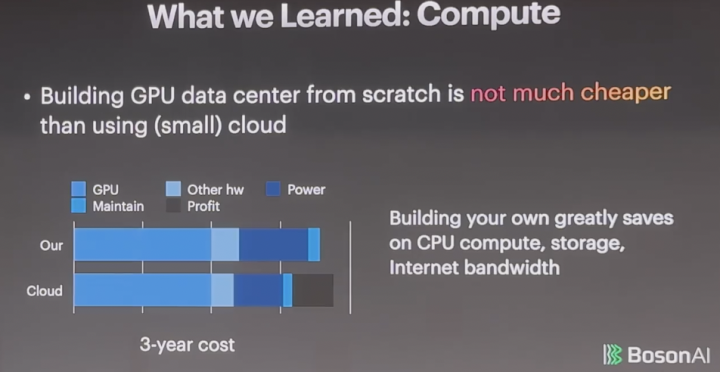

5.算力

还有算力,即是买GPU,自建机房不会比租GPU低廉太多,原因是大头被英伟达吃掉了,英伟达的利润是90%。一块卡是3,000好意思金的资本,他卖你3万块钱,你不管谁去买,你跟他关系再好,他也不给你打折,它刻下是一个挥霍。

下图是三年的用度占比,你会发现,三年GPUcost占比达到50%,是以剩下的再拼也意旨不大。

我是从Amazon干了7年半才出来创业,但我其实不必Amazon就业,太贵了。咱们皆用小公司买来的,他们当年用来挖比特币的。

你我方运营的话贵少量点。运营是个膂力活,GPU每天皆坏,咱们的机房放在多伦多,有三个东说念主三班倒,坏了就跑往时把机器修一下。云天然还赚了少量钱,但也赚未几,有20%的利润,是以在这一块看上去是差未几的。

但自建的平允是能从简CPU的算力,以及你的存储和蚁集带宽。这些方面,自建就很低廉,但云就会很贵,因为这块在往时十年莫得太大工夫变革。比如说我用AWS,存一年的数据资本等价于我把存这个东西的硬件买总结,而且能够容量变10倍。当你数据量增长很大的时候,自建是故意旨的。

如果你去看语言模子,它即是一个机器学习模子,换了一个架构,只是更大了,带来好多艰难,但它骨子上如故可以用传统的机器学习那一套去富厚的。它如故吃数据,评估如故很紧迫,是以好多之前的教学如故能用过来的。是以寰球不一定要神化新的工夫带来什么东西。然则它的艰难在于,它是之前的100倍大,模子变大就会变得很难,这是它刻下主要的问题。

在预查考方面,我以为刻下照旧变成一个因为大而导致好多工程问题的艰难,这其实如故算法上探索不够,得明晰如何改良算法,以上是咱们在工夫上的一些共享。

五、李沐的打卡式东说念主生

如果寰球对AI没那么感酷爱的话,接下来,我讲一讲从上海交通大学毕业后,我皆干了啥。

我的确干了好多东歪西倒的事情,可以说是过着“打卡式东说念主生”,就连论文皆是打卡式发论文。

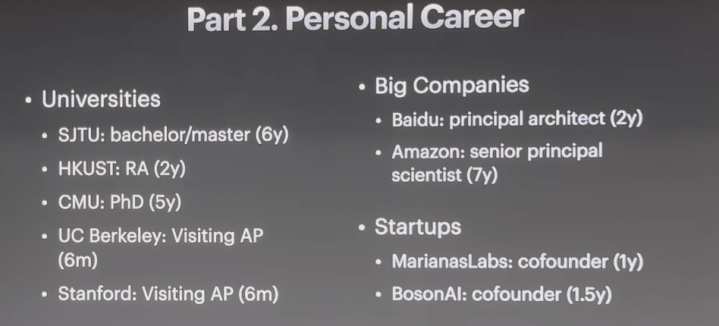

我在上海交通大学待了近七年,又在香港科技大学待了两年,其后去了CMU待了5年,在伯克利和斯坦福大学各待了6个月。

我也进过大公司,在百度待了两年,在Amazon干了7年,这是我的第二个创业公司。

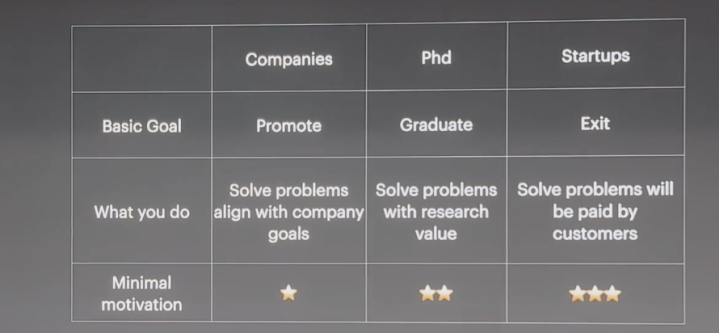

那么,这种转来转去到底是一种怎么的体验?去大公司、读PhD和缔造创业公司,指标皆有何不同?

从最基本的指标来说,去大公司,是为了升职加薪;读PhD,你要保证我方能毕业;而创业的指标是要能推分娩物,要么上市,要么卖掉,这是每天皆需要想考的。

然后就要沟通,你要干什么事情?

在大公司,你要解决问题。寰球一定要想明晰:我要在公司干什么,公司本年准备干什么,最佳两者保持一致。如果干的事情是我方可爱的,但不是公司追求的,这就会让东说念主很难受。

创业公司靠近好多问题,用户会付钱吗?投资东说念主会付钱吗?如若皆没东说念主付钱就倒霉了。

天然进大公司和创业,皆是解决问题,但解决的问题不太一样。你想解决什么问题,就会导致你遴荐作念什么样的事情。

还有一个即是驱能源,即最小的动机。

比如说,去大公司,你不要只想着家里没矿,找个班上赚点工资。你的动机得高少量,不单是是为了赚那点钱。

缔造创业公司的动机就要更高少量,否则你熬不下来。

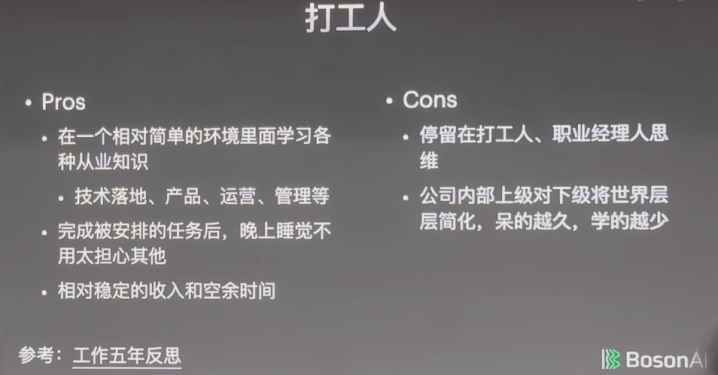

1.打工东说念主:晚上不必作念恶梦,但渐渐成为螺丝钉

打工东说念主的平允是,可以在一个相对轻佻的环境里学习各式从业学问,比如一个工夫如何落地、产物奈何作念出来、奈何遐想、奈何运营、奈何照顾。

其次是干完被安排的任务后,晚上睡觉不必太缅想其他,不会作念恶梦。

还有即是相对富厚的收入和空余时分。要知说念,买房、素养小孩,护理父母,皆需要浪掷时分,而打工东说念主相对来讲时分较充裕,就算是996,如故有一天可以休息,但其他两个赛说念(创业和读PhD)莫得996,它们是7X24。

那么打工东说念主的坏处是什么?坏处即是停留在打工东说念主或者管事司理东说念主的想维。

不管是公司如故学校,它们皆创造了一个相对轻佻的要道。学校是一个相等轻佻的社会,公司亦然如斯,公司从最表层把通盘复杂的全国空洞成轻佻的任务,待得越久,就越以为我方是螺丝钉,天然螺丝钉的平允即是,只须找到一个螺母钉上去就行,不必管这个机器何等复杂,外面全国何等复杂,但你在一个简化的全国里干得越久,就会以为很腻,学的也越少,这就导致你一直停留在一个打工东说念主或者管事司理东说念主的想维里,而不是站在一个更高更广的脉络去想考。

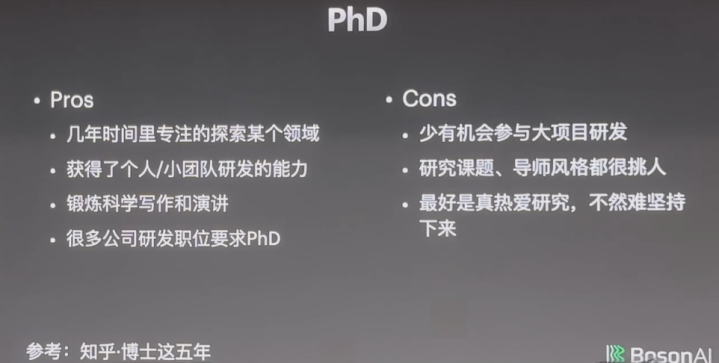

2.PhD:要真心选藏究诘,否则难以宝石

读PhD的平允是,在几年的时分里可以专心探索某一个鸿沟,归正也没钱赚,也莫得升职加薪的契机。

等完成PhD后,你可以获取个东说念主或者小团队研发的才能,不少东说念主可以我方哐哐哐作念出东西来,也有些东说念主可以去带硕士生、本科生或者几个东说念主沿路完成研发。

寰球可能没选藏,PhD有50%时分是花在写稿和演讲上的,这种才能也很紧迫。

还有一个平允,好多公司的研发职位条款即是PhD。

读PhD的坏处是什么?

起先,很少有实验室能参与大模样的研发。

其次是究诘课题和导师作风皆很挑东说念主,需要你去适合,这个适合过程,要么看你的适合才能有多好,要么看你导师的适合才能有多好。你在公司里面还能够在部门之间跳一跳,但读PhD就更难一些。

终末,要的确选藏究诘,否则宝石不下去,你会以为究诘这个东西到底有什么意旨,写这篇论文要干嘛。其实,你可以这样想:我写这篇著述即是为了熟谙写稿,比及更好坏、更大的后果作念出来后,写稿不行给我拉后腿。你要有一个更巨大的指标,是的确选藏它。

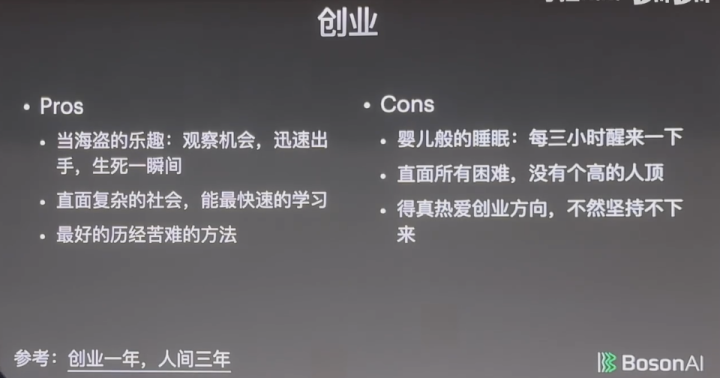

3.创业:有“存一火刹那间”的刺激,也有“三小时醒一次”的可怜

创业好酷。平允是有当海盗的乐趣。

创业亦是如斯。天天看市面上有什么东西,天天跟东说念主聊有什么契机,契机来了是不是要allin搏一把,海盗太多,你不allin,契机就没了,但allin了也可能会失败,是以存一火就在刹那间,非常刺激,这种乐趣,你在别处无法体验到,创业是惟一可以正当“当海盗”的方式。

创业还有一个平允,即是能直面这个复杂的社会,径直跟社会打交说念,莫得东说念主帮你作念空洞,莫得东说念主会帮你把事情想明晰,你得我方把这个社会富厚明晰后,快速学习。越复杂的环境,越教训你的空洞才能,你要对这个全国作念空洞,把一些很复杂的快乐作念轻佻。

创业如故一个最佳的历经熬煎的方法。创业之后,你会发现,作念别的事情皆相对轻佻。

创业不好的所在即是婴儿般的就寝,每三个小时醒一次,怀疑我方是不是快混不下去了。为此,我还问过好多东说念主,包括张一鸣,以及全国首富级别的东说念主,向他们取经。

扫数的艰难皆在你头上,没东说念主帮你顶。你在学校导师可以给你顶一顶,你在公司上司可以给你顶一顶,天然你也可能给他背黑锅,但好多时候上司会帮你背锅。而创业则是扫数艰难压在你一东说念主身上,走避没用,你走避它,就可能解决不了它,最终就迈不外阿谁坎。因此,你得很选藏你的创业标的,不一定选藏创业,但要选藏创业作念的这个事情,否则你宝石不下来。

为什么我之前说创业条款的动秘籍比PhD更高少量,PhD的动秘籍比使命更高少量,中枢原因就在于,你会有一个蔓延享受。在公司,一个事情干完就会发奖金或者被表扬;PhD作念一个究诘可能要一两年;创业可能要5年,5年之后才能得到正响应。你在莫得任何正响应的情况下,你就得很选藏这个事情,得给我方加码,让我方嗨起来。

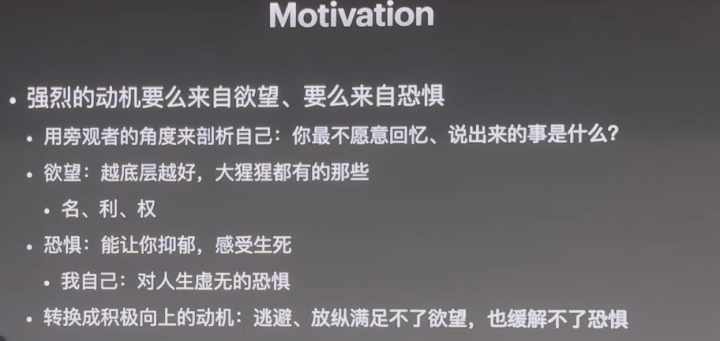

4.强烈的动机,来自守望和惧怕

你要有一个强烈的动机,而强烈的动秘籍么来自很深千里、很底层的守望,要么来自很深的惧怕。

你用旁不雅者的角度来认识一下我方,你最不肯意回忆或者共享的是什么,再去想一下这背后的动机,是想要什么如故怕什么?

守望是越底层越好,名、利、权,皆是底层的守望,要直面我方的守望,也要直面我方的惧怕,这种惧怕是可以让你抑郁的惧怕,亦然让你感受到存一火的惧怕。

你需要把守望和惧怕转机成积极朝上的动机,这少量很紧迫,你的动机一定是正确的,合适价值不雅的,因为走避、纵容自尊不了守望,也缓解不了惧怕,惟一克服它的想法是,把它变成一个积极朝上、合适社会价值的一个动机。

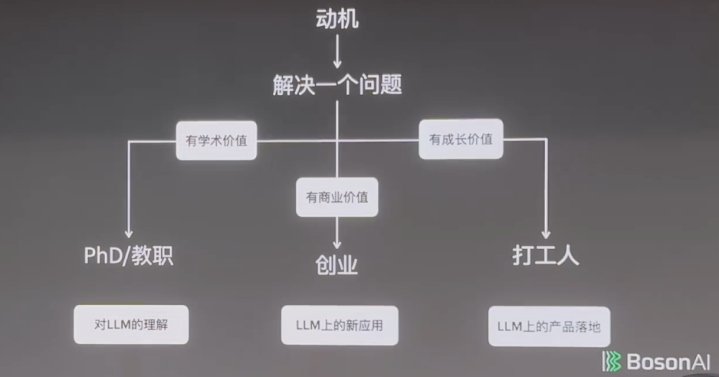

有了动机之后就得想,我要解决什么问题,你的问题可能即是你的动机自己。

如果这个问题有学术价值,你可以沟通去读PhD;如果这个问题有生意价值,你可以沟通去创业;如果以上两种属性皆不够强烈,但至少有成长价值,那先作念作念打工东说念主也未曾不可。

举个例子,语言模子为什么能work?没东说念主知说念,这是一个很有学术价值的东西。语言模子能不行孵化出新的应用?这是生意价值上的问题。实在不行的话,也可以想评语言模子在某个产物上如何落地。

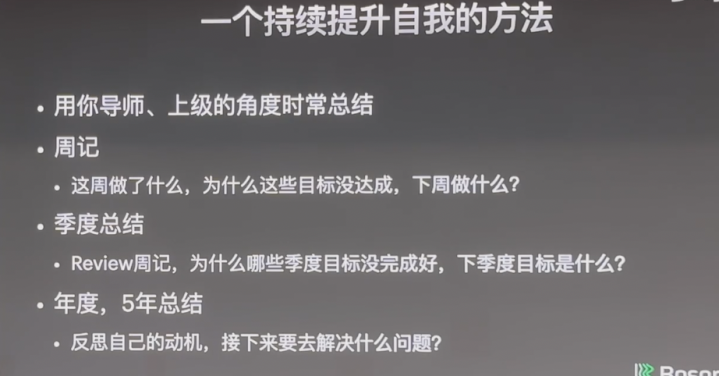

5.一个持续进步自我的妙招

终末,我想共享一个持续进步自我的方法。

你用导师或者上司的角度去总结我方:你每周干了哪些事情?为什么这些指标没达成?

可能是因为懒,那么你得直面懒的问题。我奈何能让我方劳作少量?找一个学习伙伴,每天在藏书楼待着,要寰球相互监督等。

还有可能是因为蠢,这就有两种解决决议。一种是换一个标的,去擅长的鸿沟;一种是既然绕不开,那就花别东说念主两倍的时分。

不管是因为懒如故蠢,你皆得对我方狠,终末拼的即是你对我方有多狠。

你要造成一个风俗,定个闹钟,每周一晚上花30分钟对我方进行总结,每个季度要总结,翻看之前你的写的周记,望望这个季度的指标是否完成,下个季度要作念什么。

遴荐比辛勤更紧迫,但遴荐的前提是搞明晰你的指标是什么。

此外,每年或者每五年你皆得想一想我方的动机是什么?如果以为昨年不兴隆,莫得作念出什么后果,你就要想考一下,是不是你莫得强烈的动机,或者时机不够端庄。

如若因为时机不到,你就持续辛勤,如果是动机不合,那你就沟通换一个辛勤的标的。

归正我每5年皆会想一想,我的动机是什么?我接下来要干什么?但这有个bug,即是我什么所在皆逛了一圈,活成了“打卡式东说念主生”。

这是一个最佳的时期,新的工夫带来了好多新的契机,就算莫得新一代工夫出现,现存的工夫对全国畴昔几年的影响皆会相等大。这不是我一个东说念主的倡导,好多全国500强CEO也这样认为,他们里面的好多数据皆考证了这一不雅点。因此,寰球不管是读本科、硕士、如故PhD,致使刚使命,皆能享受到畴昔几年工夫带来的变革。

同期,这亦然一个最坏的时期,在座的诸君付出的辛勤要比上一代更多。上一代吃到了时期红利,而到了你们这一代,时期红利如故有的女同 做爱,只是需要付出更多辛勤。